哈喽,大家好,我是 @梁粤 Leo !

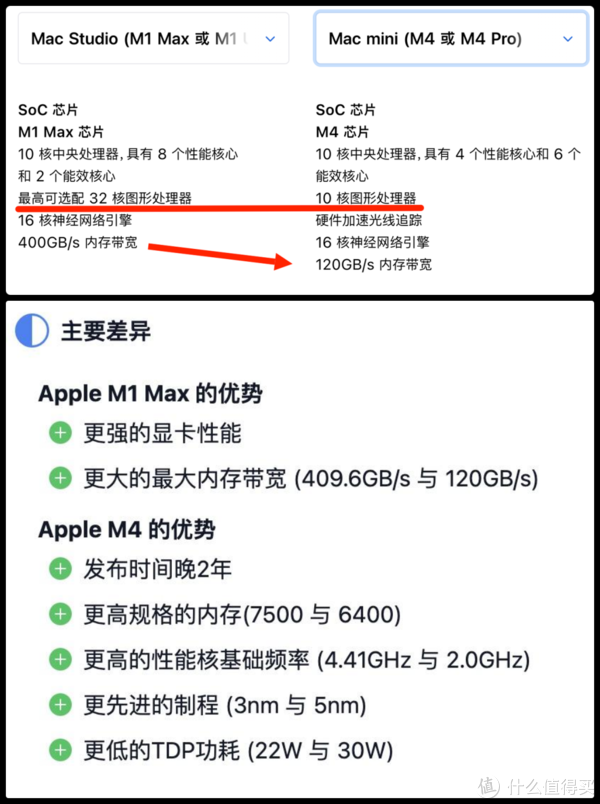

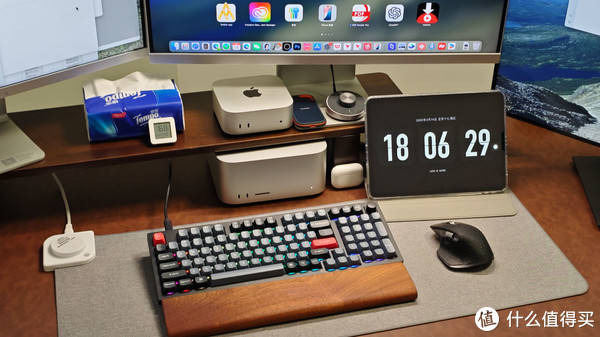

在本地化部署Deepseek时,选择合适的硬件设备至关重要。最近我在部署Deepseek R1时,就面临了一个选择:是选择M1 MAX+32G内存的Mac Studio,还是选择M4芯片+16G内存的Mac mini?这个问题不仅涉及到Mac芯片的硬件性能,还涉及到Deepseek R1的具体需求。所以,有必要来好好聊聊。

核心性能对决

M4芯片的Mac mini优势在于:CPU和NPU的性能更强

CPU:得益于更高的性能核心频率(4.41GHz VS 3.2 GHz)和更先进的3nm制程,M4芯片在CPU性能表现上还是略胜M1 Max一筹,特别是单核性能可谓全面碾压M1 Max。这表示在需要CPU运算的AI场景,M4芯片的Mac mini会有明显速度优势。

NPU:M4采用了最新一代神经网络引擎(NPU),在纯AI任务(如 Stable Difusion 生图测试)中,M4仅需9秒完成,而M1 Max需88秒,效率提升近10倍。这表明在依赖NPU的AI推理任务中,M4优势更明显。

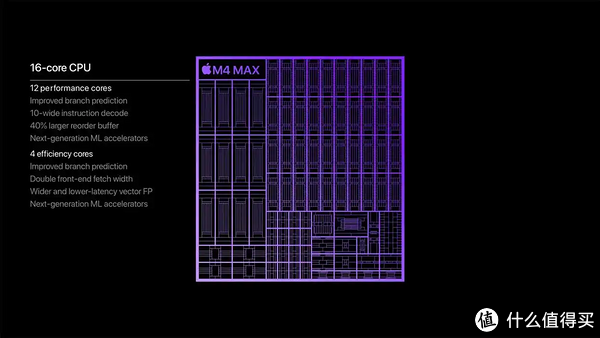

M1 Max芯片的Mac Studio优势在于:GPU和内存带宽更强

GPU:M1 Max搭载的32核GPU拥有10.4 TFLOPs浮点算力,而M4的10核GPU仅有4.6 TFLOPS。 图形计算能力更强。

内存带宽:M1 Max的400GB/s带宽明显高于M4的120GB/s,直接影响模型加载效率。内存带宽对大模型推理时的数据传输速度至关重要,尤其在处理32B模型时优势更明显。

综合来看,M4芯片的单核性能更强,且支持 AMX 指令加速,对CPU推理有优化。但M1 MAX的32核GPU在并行计算(如模型推理)中更具优势,尤其是搭配 32GB 内存可处理更大数据量。所以,Mac Studio的32GB内存更适合处理大模型,而Mac mini的16GB可能限制模型加载规模。

模型选择建议

DeepSeek R1:14B:DeepSeek-R1:14b的最低要求是16GB内存,适合快速问答 / 简单推理场景,可在M4 Mac mini上运行,但16GB内存可能限制批量大小或响应速度。若需更高效率,建议使用M1 Mac Studio的32GB内存。

DeepSeek R1:32B:DeepSeek-R1:32b 的最低要求是32GB内存,适合复杂逻辑 / 长文本生成,必须部署在M1 Mac Studio上,32GB内存是基本需求,且M1 MAX的GPU核心和带宽更适合大模型计算。

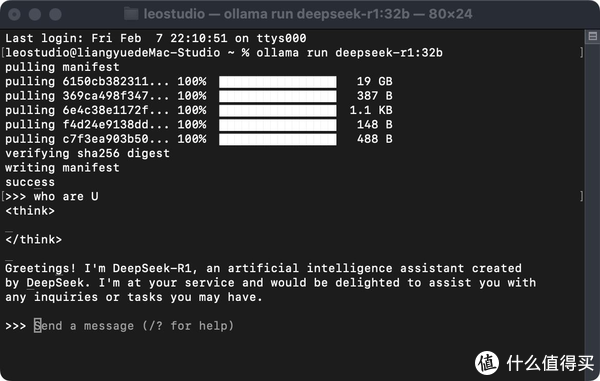

我在Mac Studio上成功部署了deepseek R1:14b和deepseek R1:32b。14b模型非常流畅,32b会有明显感觉慢了不少。

这是我M1 Max的Mac studio在跑deepseek R1:32b模型时的内存压力,基本维持在85%左右。如果同时运行一些软件或是打开多个网页,卡顿就比较明显了。

总结

若以32B模型为主,优先选择M1 MAX Mac Studio;若侧重14B模型且接受内存限制,M4 Mac mini的CPU效率可能更高,但实际体验可能受内存影响。建议根据任务规模和内存需求权衡:大模型选Mac Studio+32B,轻量级任务可选Mac mini+14B,不过,如果你预算充足,建议等待搭载M4 Ultra的Mac Studio(预计2025上半年发布)。

本文来源于MSN作者:什么值得买,文中观点仅代表作者本人,本站仅供信息存储